最近,Apple 公司與加州大學聖塔芭芭拉分校的研究合作夥伴,向公眾演示並詳細介紹了一項開創性的算法,該算法能夠從動態 RGB 圖像中在線重建 3D 圖像。

雙方合作的研究小組克服了低紋理區域的難題,致力於解決圖像重建中的固有模糊問題,他們關注那些可立即使用的實際解決方案,以便將來在智能手機等行動裝置上推廣應用。

雙方合作的研究小組克服了低紋理區域的難題,致力於解決圖像重建中的固有模糊問題,他們關注那些可立即使用的實際解決方案,以便將來在智能手機等行動裝置上推廣應用。

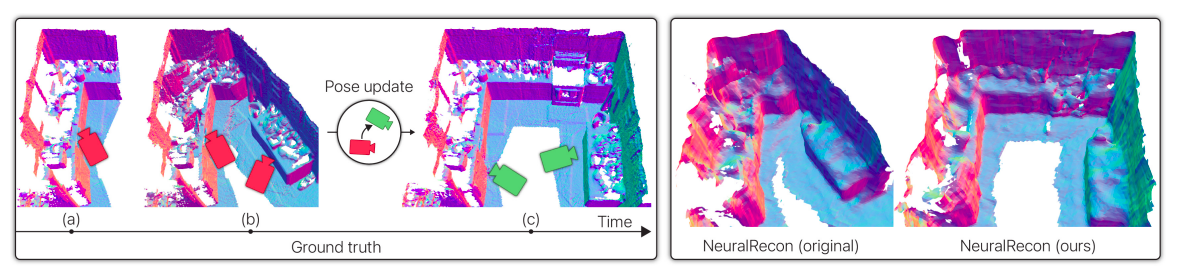

該新算法以歷史觀測結果為基礎,生成了精確的增量重建,有效解決了同步定位與地圖構建(SLAM)系統的動態性問題,確保與 SLAM 的更新一致。

該新算法以歷史觀測結果為基礎,生成了精確的增量重建,有效解決了同步定位與地圖構建(SLAM)系統的動態性問題,確保與 SLAM 的更新一致。

以前,在密集的純 RGB 重建領域,通常沒有充分考慮在線應用中相機姿態估計的動態特性, 在重建過程中依然採取靜態輸入圖片的傳統表述。

在算法中,科研團隊成功地引入了動態特性,並將其集成到了現有的 RGB 技術中。在受到 BundleFusion(一種採用線性更新算法將新視圖集成到場景中的 RGB-D 技術)啓發後,該團隊進行了研究,對舊視圖進行瞭解構,然後重新整合,以提供位置數據。

Apple 和加州大學聖塔芭芭拉分校的研究合作夥伴推出了一種獨特的、以深度學習為基礎的非線性整合技術。旨在推動NeuralRecon等技術的在線重建,該技術的實施依賴於學習得到的非線性更新規則。

他們引入了 LivePose 數據集,以驗證他們的方法。這一數據集具有開創性,包括了由 BundleFusion 生成的 ScanNet 完整動態姿勢序列。這個數據集在評估他們的技術和促進未來研究方面扮演著至關重要的角色。

此次重要突破有望為增強現實、虛擬現實和其他需要準確的 3D 建模的領域帶來新的前景。