iPhone 鏡頭的像素相比起現時市面上不少旗艦手機為低,但 Apple 的拍攝效果得益於優秀的算法優化,令其一直處於受歡迎位置。Apple 於首款雙鏡手機 iPhone 7 Plus 上帶來「人像模式」的新功能。可以通過立體匹配算法,同時使用兩個鏡頭拍攝畫面,然後匹配到不同畫面的像素,從而得出場景特徵的「深度信息」,拍出自帶景深的照片。

算法在隨後的新機型, iPhone 8 Plus、iPhone X 以上機型後,還增加了「人像光效」功能,可以在人像模式或者後期編輯裡生成各種影樓級的打光效果,像是「攝影室燈光」可提亮面部特徵、「輪廓光」實現更加戲劇化的定向照明、「舞台光」讓主體在聚光燈下突顯出來、「單色舞台」提供經典的黑白舞檯燈光等。

但是,這個算法對於只有單鏡頭的 iPhone XR 不夠好,沒有辦法像雙鏡手機一樣記錄畫面的深度信息,只能夠實現部分功能。

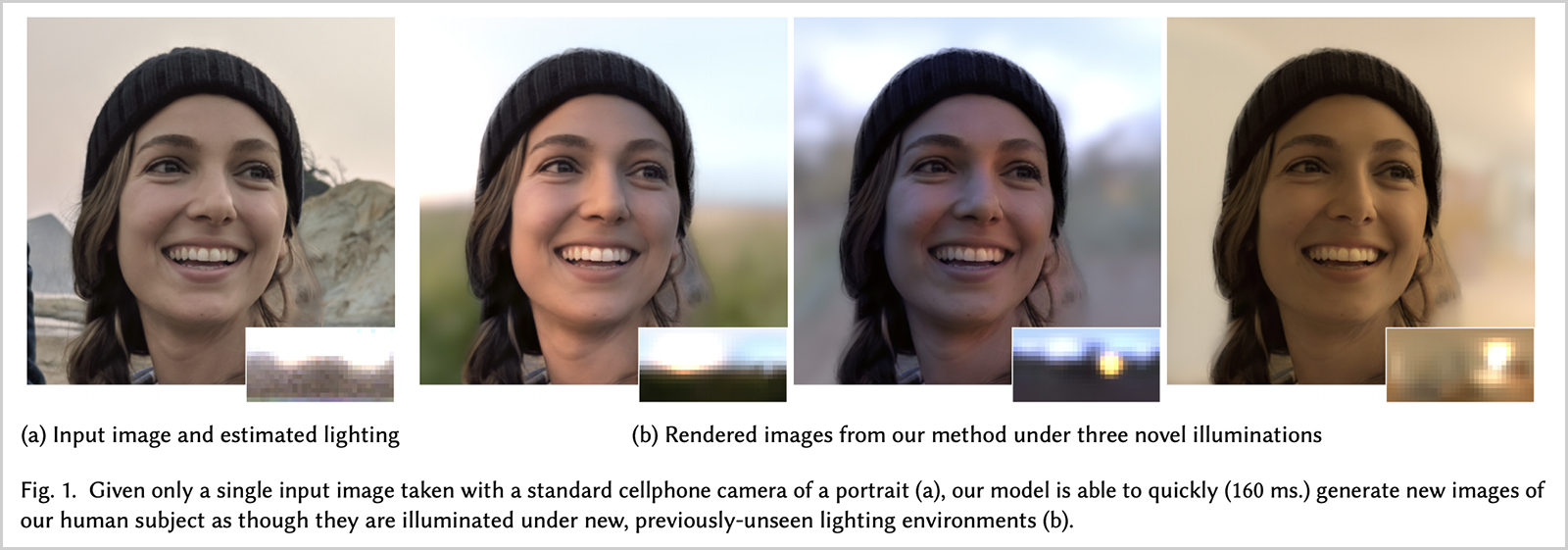

好在最近來自加利福尼亞大學聖地亞哥分校的開發人員給我們帶來了一種能夠「重建」人像光效的方法,令到在單鏡頭手機也能有著不錯的拍攝效果。

根據研究人員的介紹,稱該技術是通過 AI 判斷照片中的人物信息,然後在神經網絡的幫助下重建出臉部的光照,允許用戶在 3D 空間中將光源打在任何地方,得以模擬更多的打光效果,甚至可以選擇性地改變背景與之匹配,功能更加的強大。

研究人員稱目前生成一張 640×640 像素的照片僅需要 160 毫秒,但是到了一張 1200 萬像素的照片時,時間就變成了 4.7 秒。由 18 個人組成的demo 訓練神經網絡的樣本量也不佳,需要後期的添加。